Meta publie le code dans l'intelligence artificielle en libre accès sous le nom lien d'image, qui prédit des relations entre des données similaires à la façon dont les gens perçoivent ou imaginent leur environnement. Alors que les générateurs d'images comme Midjourney, Stable Diffusion et DALL-E 2 lient les mots aux images, vous permettant de créer des scènes visuelles basées uniquement sur une description textuelle, ImageBind va au-delà. Il peut lier du texte, des images ou de la vidéo, de l'audio, des mesures 3D, des données de température et des données de mouvement - et le fait sans avoir besoin d'une formation préalable à chaque occasion. Il s'agit d'une première étape d'un framework qui sera éventuellement capable de générer des environnements complexes à partir d'entrées simples telles qu'une invite de texte, une image ou un son (ou une combinaison de ceux-ci).

Vous pouvez considérer ImageBind comme une approximation de l'apprentissage automatique à l'apprentissage humain. Par exemple, si vous vous trouvez dans un environnement dynamique, comme une rue animée d'une ville, votre cerveau absorbe (la plupart du temps inconsciemment) des images, des sons et d'autres sensations sensorielles pour obtenir des informations sur les voitures qui passent, les grands immeubles, la météo, etc. . Les humains et les autres animaux ont évolué pour traiter ces données pour nos avantages génétiques : la survie et la transmission de notre ADN. (Plus vous en savez sur votre environnement, plus vous pouvez éviter le danger et vous adapter à votre environnement pour mieux survivre et prospérer). Au fur et à mesure que les ordinateurs imitent les connexions multisensorielles des animaux, ils peuvent utiliser ces connexions pour générer des scènes entièrement réalisées basées sur des éléments de données limités.

Ainsi, même si vous pouvez utiliser Midjourney pour créer "un basset dans un costume de Gandalf en équilibre sur un ballon de plage" et obtenir une photo relativement réaliste de cette scène étrange, un outil d'IA multimodal comme ImageBind pourrait finir par créer une vidéo avec le chien avec des informations pertinentes. sons, y compris un salon détaillé, la température ambiante et l'emplacement exact du chien et de tous les autres dans la scène. "Cela crée une excellente opportunité de créer des animations à partir d'images statiques en les combinant avec des invites audio", notent les chercheurs de Meta dans leur blog destiné aux développeurs. "Par exemple, un créateur peut combiner une image avec un réveil et un coq qui chante et utiliser un signal audio pour segmenter le coq ou le son du réveil pour segmenter l'horloge et animer les deux dans une séquence vidéo."

Quant à ce qui peut être fait d'autre avec ce nouveau jouet, il indique clairement l'une des ambitions fondamentales de Meta : VR, réalité mixte et métaspace. Par exemple, imaginez un futur casque capable de créer des scènes 3D entièrement réalisées (avec son, mouvement, etc.) à la volée. Ou les développeurs de jeux virtuels pourraient éventuellement l'utiliser pour s'épargner une partie importante du travail minutieux du processus de conception. De même, les créateurs de contenu pourraient créer des vidéos immersives avec des bandes sonores réalistes et des mouvements basés uniquement sur du texte, des images ou de l'audio. Il est également facile d'imaginer comment un outil comme ImageBind ouvre de nouvelles portes dans l'accessibilité en générant des descriptions multimédias en temps réel pour aider les personnes ayant une déficience visuelle ou auditive à mieux comprendre leur environnement.

Intéressant aussi : Les meilleurs outils basés sur l'intelligence artificielle

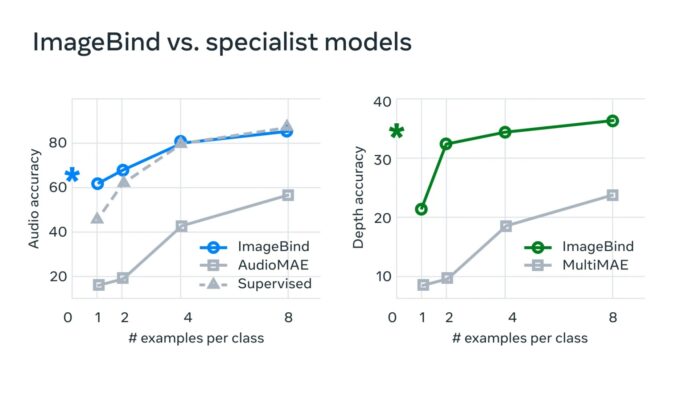

"Dans les systèmes d'IA typiques, il existe une intégration spécifique (c'est-à-dire des vecteurs de nombres qui peuvent représenter des données et leurs relations dans l'apprentissage automatique) pour chaque modalité pertinente", explique Meta. « ImageBind montre qu'il est possible de créer un espace d'intégration commun pour plusieurs modalités sans avoir à s'entraîner sur les données avec chaque combinaison individuelle de modalités. Ceci est important car les chercheurs ne peuvent pas créer d'ensembles de données avec des échantillons contenant, par exemple, des données audio et des données thermiques d'une rue animée de la ville, ou des données de profondeur et une description textuelle d'une falaise en bord de mer. »

Meta pense que cette technologie finira par aller au-delà des six "sens" actuels, pour ainsi dire. "Bien que nous ayons étudié six modalités dans notre étude actuelle, nous pensons que l'introduction de nouvelles modalités qui connectent autant de sens que possible - comme le toucher, la parole, l'odorat et les signaux cérébraux IRMf - permettra des modèles d'IA centrés sur l'humain plus riches." Les développeurs intéressés par l'exploration de ce nouveau bac à sable peuvent commencer par plonger dans le code open source de Meta.

Lire aussi :